Giới thiệu về Học sâu ( Deep Learning ) - Sự liên quan giữa Machine Learning và Deep Learning

( Weekly Study - IoT/AI ) Trong những năm sơ khai, trí tuệ nhân tạo (AI) tập trung nhiều vào các hệ thống dựa trên quy tắc sẽ đưa ra dự đoán bằng cách sử dụng các bộ quy tắc được xác định từ trước, cung cấp bởi một chuyên gia về chủ đề đó. Tuy nhiên, những hệ thống này rất mỏng manh và chỉ có thể dựa vào những “ý kiến chuyên gia", điều này cuối cùng khiến chúng trở nên lỗi thời. Khi quy mô và số lượng dữ liệu tăng lên, các phương pháp này được thay thế bằng cách tiếp cận theo hướng dữ liệu lớn hơn, học máy.

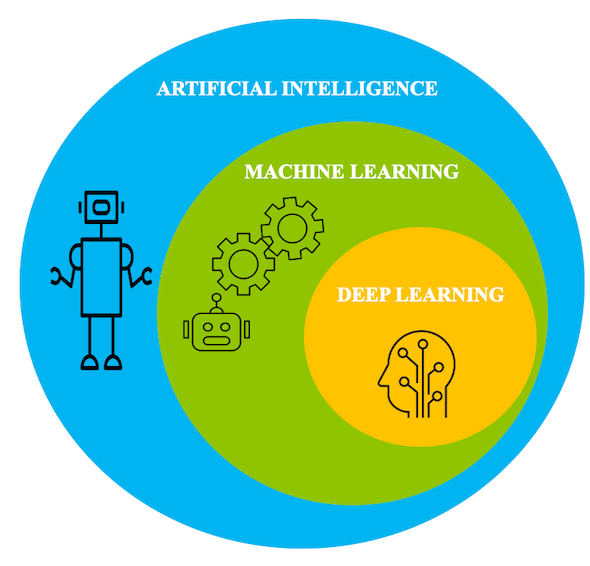

Sự liên quan giữa học máy với học sâu

Học máy là một tập hợp các thuật toán và công cụ giúp máy móc hiểu các mẫu bên trong dữ liệu và sử dụng cấu trúc cơ bản này để thực hiện suy luận về một nhiệm vụ nhất định. Có nhiều cách mà máy móc hướng tới để hiểu được những mô hình cơ bản này. Nhưng học máy liên quan như thế nào đến học sâu? Trong bài viết này, Weekstudy cung cấp thông tin tổng quan về cách học sâu phù hợp với lĩnh vực này và cũng thảo luận về một số ứng dụng và thách thức của nó.

Ngày càng có nhiều quan niệm sai lầm rằng học sâu là một công nghệ cạnh tranh với lĩnh vực học máy. Trong bài viết này, chúng tôi thảo luận về một số lầm tưởng này và giải thích cách học sâu liên quan đến học máy và lợi thế của việc sử dụng các thuật toán học sâu trong một số ứng dụng nhất định.

Nói một cách dễ hiểu, học sâu là một lĩnh vực phụ của học máy. Với sức mạnh tính toán tăng tốc và tập dữ liệu lớn, các thuật toán học sâu có thể tự học các mẫu ẩn bên trong dữ liệu để đưa ra dự đoán.

Về bản chất, bạn có thể coi học sâu là một nhánh của học máy được đào tạo dựa trên lượng lớn dữ liệu và xử lý nhiều đơn vị tính toán hoạt động song song để thực hiện các dự đoán.

Học sâu và bộ não con người

Trong nỗ lực tạo ra các hệ thống học tương tự như cách con người học, kiến trúc cơ bản cho việc học sâu được lấy cảm hứng từ cấu trúc của bộ não con người. Vì lý do này, khá nhiều thuật ngữ cơ bản trong học sâu có thể được ánh xạ trở lại thần kinh học. Tương tự như cách các tế bào thần kinh hình thành các khối xây dựng cơ bản của não, kiến trúc học sâu chứa một đơn vị tính toán cho phép mô hình hóa các hàm phi tuyến được gọi là perceptron.

Sự kỳ diệu của học sâu bắt đầu với perceptron khiêm tốn. Tương tự như cách "nơ-ron" trong não người truyền các xung điện trong hệ thống thần kinh của chúng ta, tế bào cảm thụ nhận một danh sách các tín hiệu đầu vào và chuyển chúng thành tín hiệu đầu ra.

Perceptron nhằm mục đích hiểu được biểu diễn dữ liệu bằng cách xếp chồng nhiều lớp lại với nhau, trong đó mỗi lớp chịu trách nhiệm hiểu một số phần của đầu vào. Một lớp có thể được coi là một tập hợp các đơn vị tính toán học cách phát hiện sự xuất hiện lặp lại của các giá trị.

Mỗi lớp perceptron chịu trách nhiệm giải thích một mẫu cụ thể trong dữ liệu. Một mạng lưới các perceptron này bắt chước cách các nơ-ron trong não tạo thành một mạng lưới, vì vậy kiến trúc được gọi là mạng nơ-ron (hay mạng nơ-ron nhân tạo).

Mạng lưới thần kinh nhân tạo

Phần này cung cấp tổng quan về kiến trúc đằng sau học sâu, mạng nơ-ron nhân tạo (ANN) và thảo luận về một số thuật ngữ chính.

Như thể hiện trong hình sau, mỗi perceptron được tạo thành từ các phần sau:

Bước 1 - Tính tổng trọng số

- Các đầu vào từ x1 đến xn, cũng có thể được ký hiệu bằng vectơ X. Xi đại diện cho mục nhập thứ i từ tập dữ liệu. Mỗi mục nhập từ tập dữ liệu chứa n biến phụ thuộc.

- Các trọng số từ w1 đến wn, có thể được ký hiệu là ma trận W

- Một số hạng thiên vị b, là một hằng số

Bước 2 - Chức năng kích hoạt

Đầu ra của bước 1 bây giờ được chuyển qua một chức năng kích hoạt. Hàm kích hoạt g là một hàm toán học cho phép bạn biến đổi kết quả đầu ra sang định dạng phi tuyến tính mong muốn trước khi nó được gửi đến lớp tiếp theo. Nó ánh xạ kết quả tổng kết đến một phạm vi mong muốn. Điều này giúp xác định xem liệu nơ-ron có cần được kích hoạt hay không.

Ví dụ, một hàm sigmoid ánh xạ các giá trị đến phạm vi [0,1], rất hữu ích nếu bạn muốn hệ thống của mình dự đoán các xác suất. Làm như vậy cho phép bạn lập mô hình các ranh giới quyết định phi tuyến tính phức tạp.

Mạng nơron nông

Trong phần trước, bạn đã thấy các phép tính xảy ra trong mỗi perceptron. Bây giờ, bạn sẽ thấy các perceptron này phù hợp với mạng như thế nào và quy trình được hoàn thành như thế nào.

Ở dạng cơ bản nhất, mạng nơ-ron chứa ba lớp: lớp đầu vào, lớp ẩn và lớp đầu ra. Như thể hiện trong hình sau, một mạng chỉ có một lớp ẩn được gọi là mạng nơron nông.

Các tính toán được thảo luận trong các phần trước xảy ra cho tất cả các nơron trong mạng nơron bao gồm cả lớp đầu ra và một lần truyền như vậy được gọi là truyền chuyển tiếp. Sau khi hoàn thành một lần chuyển tiếp, lớp đầu ra phải so sánh kết quả của nó với các nhãn chân thực trên mặt đất thực tế và điều chỉnh trọng số dựa trên sự khác biệt giữa giá trị trung thực mặt đất và các giá trị dự đoán. Quá trình này là một quá trình truyền ngược qua mạng nơ-ron và được gọi là quá trình lan truyền ngược. Mặc dù toán học đằng sau sự truyền ngược nằm ngoài phạm vi của bài viết này, nhưng những điều cơ bản của quá trình này có thể được trình bày như sau:

- Mạng hoạt động để giảm thiểu một hàm mục tiêu, ví dụ, lỗi phát sinh trên tất cả các điểm trong mẫu dữ liệu.

- Tại lớp đầu ra, mạng phải tính toán tổng sai số (chênh lệch giữa giá trị thực tế và giá trị dự đoán) cho tất cả các điểm dữ liệu và lấy đạo hàm của nó đối với trọng số ở lớp đó. Đạo hàm của hàm lỗi đối với trọng số được gọi là gradient của lớp đó.

- Trọng số cho lớp đó sau đó được cập nhật dựa trên gradient. Bản cập nhật này có thể là bản thân gradient hoặc một yếu tố của nó. Yếu tố này được gọi là tỷ lệ học tập và nó kiểm soát mức độ lớn của các bước bạn thực hiện để thay đổi trọng lượng của mình.

- Quá trình sau đó được lặp lại cho một lớp trước đó và tiếp tục cho đến khi đạt được lớp đầu tiên.

- Trong quá trình này, các giá trị của gradient từ các lớp trước đó có thể được sử dụng lại, giúp tính toán gradient hiệu quả.

Kết quả của một lần truyền chuyển tiếp và lan truyền ngược là sự thay đổi trọng số của các lớp mạng và đưa hệ thống tiến gần hơn đến việc mô hình hóa tập dữ liệu được cung cấp cho nó. Bởi vì quá trình này sử dụng gradient để giảm thiểu lỗi tổng thể, quá trình hội tụ các tham số của mạng nơ-ron đến mức tối ưu được gọi là gradient descent.

Mạng nơron sâu

Mạng nơron sâu chỉ đơn giản là một mạng nơron nông có nhiều hơn một lớp ẩn. Mỗi nơ-ron trong lớp ẩn được kết nối với nhiều nơ-ron khác. Mỗi mũi tên có một thuộc tính trọng lượng gắn liền với nó, điều này kiểm soát mức độ ảnh hưởng của kích hoạt tế bào thần kinh đó đến những người khác gắn liền với nó.

Từ ‘sâu’ trong học sâu được gán cho những lớp ẩn sâu này và bắt nguồn từ hiệu quả của nó. Việc chọn số lớp ẩn phụ thuộc vào bản chất của vấn đề và kích thước của tập dữ liệu. Hình dưới đây cho thấy một mạng nơron sâu với hai lớp ẩn.

Trong phần này, Weeklystudy đã trình bày tổng quan cấp cao về cách hoạt động của mạng nơ-ron nhân tạo. Để tìm hiểu thêm, hãy xem bài viết về cách mạng thần kinh hoạt động từ đầu. Bạn cũng có thể xem xét sâu hơn về mạng thần kinh trong phần đi sâu về mạng thần kinh này.

WeeklyStudy - Kênh tri thức Việt

Nguồn: ibm.com